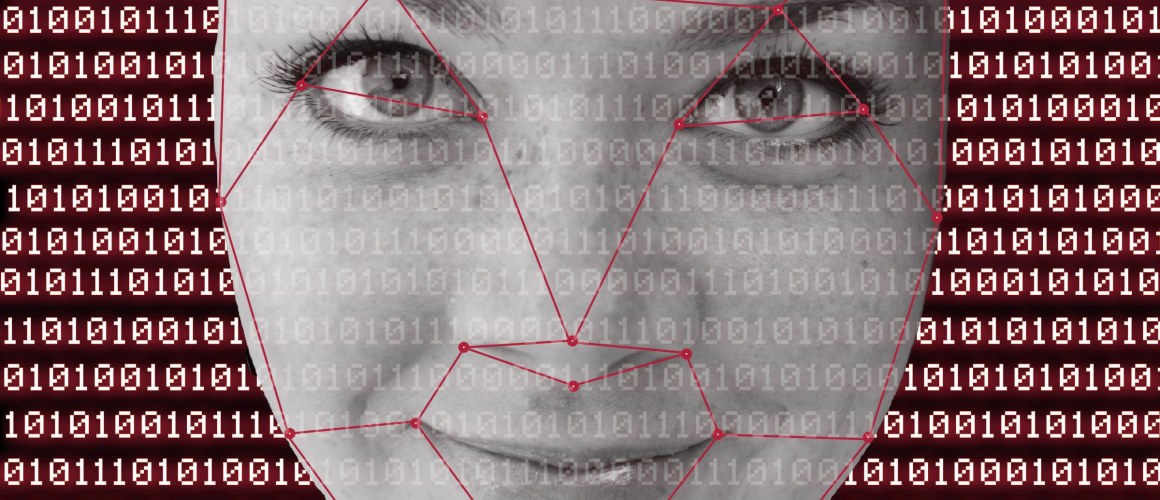

In oktober verscheen online plotseling een merkwaardige video van NOS-presentatrice Annechien Steenhuizen die een gok-app aanprijst. Ze praat houterig en haar Nederlands lijkt uit het Engels te zijn vertaald met een vertaalmachine. De video is een voorbeeld van een deepfake: beeld of geluid dat is gemaakt of aangepast door kunstmatige intelligentie (artificial intelligence of AI in het Engels). Deepfakes zijn vergelijkbaar met teksten die gemaakt worden door ChatGPT.

De video van Annechien Steenhuizen is niet de enige deepfake die recent ophef veroorzaakte. De Amerikaanse acteur Tom Hanks zou een tandartsverzekering aanprijzen en de YouTuber Jimmy Donaldson (bekend als MrBeast) waarschuwde voor nepvideo’s waarin hij Iphones weg zou geven.

Dat is oplichting, maar ook in de context van politiek en oorlog zijn deepfakes terug te vinden. Zo ging er op Facebook een vermeend audiobericht van Donald Trump rond die waarschuwde voor een aanval van Chinese en Russische bodem, waarbij 300 miljoen Amerikanen gedood zouden worden. En online zijn er beelden te vinden van de oorlog in Israël en Gaza die gemaakt zijn met programma’s als Midjourney: van Israëlische soldaten die baby’s redden tot bebloede Palestijnse kinderen die bij het lichaam van hun moeder staan.

Waarschuwen voor deepfakes

In het nieuws wordt met regelmaat gewaarschuwd voor deepfakes en AI. Dat gebeurde ook al toen de technologie nog minder goed was: in het kader van de oorlog in Oekraïne werd er gewaarschuwd en in 2018 toen komiek Jordan Peele zich voordeed als Obama in een satirisch filmpje.

Maar soms gaan deze waarschuwingen de mist in. Niet alles wat aangezien wordt voor een deepfake, is er ook daadwerkelijk een. Zo spraken Tweede Kamerleden begin 2021 via videoverbinding met een bedrieger die zich voordeed als Leonid Volkov, de toenmalige stafchef van de Russische oppositieleider Alexei Navalny. Er werd in Nederlandse media aanvankelijk geschreven dat de bedrieger gebruik had gemaakt van een deepfakefilter om zich live voor te doen als Volkov. Uiteindelijk bleek dat hij zich gewoon had geschminkt en dat er geen deepfakes in het spel waren.

De vraag is dus hoe gegrond de waarschuwingen zijn en hoe groot het gevaar van deepfakes echt is. Volgens Michael Hameleers van de Universiteit van Amsterdam, die onderzoek doet naar factchecken en misleidende informatie, zijn juist de waarschuwingen het probleem: “Ik denk dat gevaren met deepfakes voornamelijk zitten in de beschuldiging van echte informatie als deepfake. De maatschappelijke bedreiging daarvan is vermoedelijk het grootste: deepfakes komen nu nog incidenteel voor, en hebben vaak ook juist het doel om te laten zien dat deepfakes bestaan.”

Desinformatieboeman

Een artikel van Forbes begint met een recente gebeurtenis: een TikTok-gebruiker had nieuwslezeres Anne-Marie Green van CBS nagemaakt. De namaak-nieuwslezeres werd ingezet om de spot te drijven met schietpartijen op scholen: zij stelde een vraag over een schietpartij aan de TikTokker, die vervolgens een punchline met woordgrap als antwoord gaf.

Het artikel gebruikt dit incident als brug naar een bredere discussie over deepfakes. In de titel en het artikel zelf wordt gewaarschuwd voor “a new era of deepfakes”: de nep-nieuwslezers zijn een nieuw fenomeen en zouden problemen kunnen geven met de Amerikaanse presidentsverkiezingen van volgend jaar.

Deze opzet komt vaker voor bij nieuwsmedia: een incident dat te maken heeft met deepfakes wordt gebruikt om te waarschuwen voor grote gevaren in de toekomst. Er wordt in dit soort artikelen vaak gesproken van een ‘infocalyps’ of een ‘post-truth tijdperk’. Het idee daarbij is dat in de toekomst alomvattende twijfel zal bestaan over welke media wel echt zijn en welke niet, waardoor de mens niets meer kan vertrouwen. Deepfakes worden daarbij neergezet als een soort hoogtepunt van nepperij dat we in de toekomst overal zullen tegenkomen.

Maar niet alles wat een deepfake wordt genoemd, is dat ook. Het voorval met de imitatie-Volkov is één voorbeeld, maar er zijn er meer te vinden. Zo was er eind 2018 ophef over de nieuwjaarstoespraak van toenmalig president Ali Bongo van het Centraal-Afrikaanse land Gabon. De president was al een paar maanden niet in het openbaar verschenen omdat hij een beroerte had gehad. In de laatste maanden van 2018 gonsde het van de geruchten dat Bongo overleden zou zijn. In de nieuwjaarstoespraak zag de president er vreemd uit, wat uiteindelijk leidde tot een mislukte staatsgreep. Er werd gedacht dat de video een deepfake was, alhoewel na de couppoging bleek dat Bongo gewoon in leven was. Zijn opmerkelijke uiterlijk in de toespraak was volgens een neuroloog die The Washington Post sprak waarschijnlijk een gevolg van zijn beroerte. Nadat de president weer in het openbaar verscheen, bleek ook dat hij er fysiek daadwerkelijk anders uitzag.

Het voorbeeld van Bongo en dat van de imitatie-Volkov laten zien dat niet alleen deepfakes voor verwarring zorgen, maar dat ook de angst voor deepfakes dat doet. De vraag blijft welke van de twee het grootste probleem vormt.

Deepfakes in het heden: geringe invloed

Volgens onderzoeker Michael Hameleers komen deepfakes als desinformatie weinig voor, zeker vergeleken met cheapfakes. Cheapfakes zijn beelden die bewerkt zijn met (relatief) eenvoudige technieken, zoals knip- en plakwerk in Photoshop. Ook beelden die uit hun context gehaald zijn, vallen hieronder, zoals beelden uit oude conflicten die voor hedendaagse oorlogen gebruikt worden. Bij de oorlog tussen Hamas en Israël kwamen er online veel cheapfakes langs. Hameleers: “Het gevaar zit ‘m op dit moment meer in cheapfakes en voornamelijk in de decontextualisering en bewust misleidende interpretatie van authentiek materiaal. Kijk bijvoorbeeld naar recente oorlogen: het gaat bij desinformatie vaak meer om het uit de context halen van bestaand materiaal uit andere tijd, plaats of zelfs fictie.”

En als er dan sprake is van een deepfake, zijn deze vaak verre van perfect. Zo ging er vorige maand een deepfakefoto rond van Frans Timmermans, waarin hij in een vliegtuig zit met luxe hapjes. Op de foto zijn veel rare details te zien, zoals een hand met zes vingers en ongelijke brillenglazen. Deepfakes zijn dus (nog) geen overtuigende middelen voor politieke nepperij.

Er zijn wel andere domeinen waarin deepfakes het goed doen. 96 procent van alle deepfakes zijn niet-consensuele porno [pdf] en er zijn voorbeelden te bedenken van succesvolle satirische deepfakes: Gerri Baudet van Zondag met Lubach, de dansende koningin van Channel 4 en deepfake-Obama die waarschuwt voor het gevaar van de technologie. Bij deze voorbeelden is het minder belangrijk dat de deepfakes er overtuigend uitzien, want vaak zijn de consumenten van dit soort deepfakes zich ervan bewust dat de beelden nep zijn.

Verder is onderzoek gedaan naar de verspreiding van deepfakes op Twitter in de eerste maanden van de oorlog in Oekraïne. Zowel pro-Russische als pro-Oekraïense deepfakes kwamen langs, die beiden veel Tweets genereerden. Maar wat vaker voorkwam was dat mensen echte beelden deepfakes noemden, omdat ze deze ook daadwerkelijk als deepfake zagen of omdat deepfake werd gebruikt als een soort overtreffende trap van het woord fake.

Hameleers ziet dit als het grootste gevaar dat nu aan deepfakes kleeft: “Omdat er gesteld wordt dat desinformatie alomtegenwoordig en hyper-realistisch is, kan ook echte informatie als nep worden gezien, zeker als het ingaat tegen je bestaande ideeën. Dat is ook de negatieve bijwerking van het benadrukken van de bedreiging.”

Het helpt niet mee dat de waarschuwingen wellicht niet op goede argumenten berusten. Onderzoekers van verschillende Europese universiteiten hebben recent argumenten onder de loep genomen die betrekking hebben op het maatschappelijke debat rond AI. Volgens de onderzoekers wordt de impact op het informatielandschap van generatieve AI, waar deepfakes onder vallen, overdreven.

De argumenten die gebruikt worden, zijn ook terug te zien bij oudere morele panieken omtrent technologieën en media die toentertijd nieuw waren zoals videospelletjes en Youtube-video’s. De verkeerde aanname die hier wordt gemaakt is dat mensen zeer goedgelovig zijn. Ook wordt over het hoofd gezien dat er maatschappelijke instituten zijn die in het verleden de opkomst van nieuwe technologieën het hoofd hebben kunnen bieden en nog steeds betrouwbare informatie kunnen leveren.

Deepfakes in de toekomst: reden tot paniek?

Het nepnieuws op het conto van deepfakes is in het heden dus gering, hoewel er nu al wel meer voorbeelden zijn van incidenten met deepfakes dan een aantal jaar geleden. Maar veel van de angst om deepfakes richt zich zoals eerder geïllustreerd niet op het heden, maar op de toekomst. Hoe zit het daar dan mee? Staat ons een infocalyps te wachten?

Hameleers vindt van niet: “Ik denk dat we heel voorzichtig moeten zijn met het gebruiken van dergelijke termen. Gezien het merendeel van informatie geen desinformatie is, moeten we mensen blijven wijzen op betrouwbare informatie, en de bedreigingen altijd in de context plaatsen van betrouwbaar nieuws.”

Maar niks staat vast, zoals Hameleers ook aangeeft: “Uiteraard moeten we onze inzichten wel blijven updaten. Nu zien we dat decontextualisering en cheapfakes veel meer worden gebruikt dan AI, maar in de toekomst kan dit anders zijn. Het blijft dan nog belangrijk om de balans tussen risicopercepties en daadwerkelijke desinformatie te behouden, die nu echt disproportioneel is.”

Een belangrijke vraag hierbij is hoe goed de technologie uiteindelijk kan worden: stemmen zijn nu al goed na te bootsen, maar met beeld en video is dit nog veel lastiger. Volgens experts die vorig jaar met The Atlantic spraken, zullen deepfakes over een aantal jaar zo goed zijn dat ze niet van echt te onderscheiden zijn. Maar het blijft ook dan de vraag of deepfakes echt aanslaan onder makers van onwaarheden. Ook in de toekomst zal het maken van cheapfakes makkelijker blijven en kan het ook effectievere nepperij zijn, zoals een artikel van Poynter aangeeft.